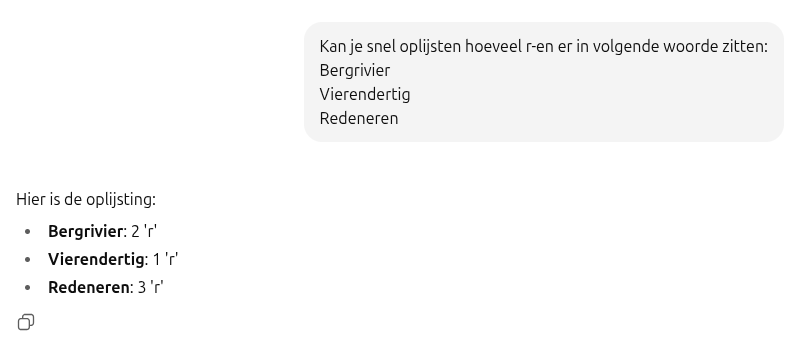

Een simpele vraag kan soms verrassende antwoorden opleveren. Neem bijvoorbeeld de vraag: “Hoeveel keer komt de letter ‘r’ voor in het woord ‘bergrivier’?” Voor de meeste mensen is het antwoord duidelijk: er zijn drie ‘r’en. Maar veel AI-systemen, zoals ChatGPT, hebben moeite met deze vraag: “The strawberry problem”. Dit roept de vraag op: waarom kunnen ze zo’n eenvoudige taak niet goed uitvoeren?

Wat is het probleem?

AI-systemen zijn erg krachtig en kunnen veel taken goed uitvoeren, zoals het schrijven van teksten of het oplossen van wiskundeproblemen. Maar soms maken ze fouten bij eenvoudige dingen, zoals het tellen van letters. Dit komt omdat AI niet “denkt” zoals mensen dat doen. In plaats van woorden te begrijpen zoals wij, werken ze met kleine stukjes tekst die “tokens” worden genoemd.

Hoe werkt tokenization?

Wanneer AI een woord zoals “bergrivier” tegenkomt, kan het dit splitsen in kleinere delen, zoals “berg” en “rivier”. Hierdoor kan de AI niet goed tellen hoeveel ‘r’en er in het hele woord zitten. Het model moet in elk deel kijken en de letters tellen, maar dat is niet iets waar het specifiek voor is getraind. Dit maakt het moeilijk voor de AI om de juiste telling te geven.

Waarom Falen AI-systemen Bij Eenvoudige Tellingen?

- Verdeelde Woorden: AI leest woorden niet als één geheel, maar als losse stukjes. Dit maakt het moeilijk om te tellen.

- Geen Focus op Tellen: AI is ontworpen om het volgende woord te voorspellen dat logisch klinkt, niet om precies te tellen. Dit betekent dat het vaak gissingen doet in plaats van systematisch te tellen.

- Herhaalde Letters: Soms worden letters die vaak voorkomen, zoals de ‘r’ in “rivier”, als één geheel gezien in plaats van als aparte letters. Dit kan leiden tot fouten in de telling.

- Willekeurige Antwoorden: AI kan soms een foutief, maar plausibel antwoord geven. Dit komt doordat het model niet altijd de juiste logica volgt.

- Geen Stapsgewijze Telling: AI geeft meestal één antwoord in één keer, zonder de mogelijkheid om stap voor stap te tellen.

Kritische Bedenking: Overmatig Vertrouwen in AI

Het zet het grote (overmatige) vertrouwen dat mensen vaak lijken te hebben in AI wat in perspectief. Veel mensen beschouwen AI als een onfeilbare bron van informatie en oplossingen. Dit kan gevaarlijk zijn, vooral wanneer AI-systemen fouten maken bij eenvoudige taken, zoals het tellen van letters. Het idee dat AI altijd correct is, kan leiden tot verkeerde beslissingen, vooral in situaties waar nauwkeurigheid cruciaal is, zoals in de gezondheidszorg of bij juridische zaken.

Het is essentieel om te beseffen dat AI, ondanks zijn indrukwekkende mogelijkheden, nog steeds beperkingen heeft. Het is geen vervanging voor menselijk inzicht en kritisch denken. Door AI te gebruiken als een hulpmiddel in plaats van een autoriteit, kunnen we de risico’s van overmatig vertrouwen minimaliseren en ervoor zorgen dat we de technologie op een verantwoorde manier inzetten.